A venda no B2B é diferente, e isso não é novidade para o mercado. O cliente visualiza a compra como uma reposição de insumo utilizada para maximizar o seu negócio, ou seja, a compra precisa contribuir para os seus resultados, exigindo que cada venda tenha características e tratativas próprias, que ganham ainda mais complexidade quando se acrescentam as dimensões continentais do nosso país e as especificidades de cada setor.

O amadurecimento de novos modelos comerciais que consigam suprir de forma eficiente esse dinamismo do mercado é almejado por quem quer se consolidar na venda B2B.

Principalmente a partir de 2013, quando a venda de smartphones no Brasil cresceu 123% (YoY), muitas iniciativas de digitalização surgiram, e foi se compondo uma miscelânea de soluções como e-commerces, marketplaces, compras coletivas, dropshipping aplicadas a diferentes modelos como B2B2B, D2B, B2B2C que geraram um cenário inédito no Brasil. Porém, dez anos depois, nenhuma dessas soluções se estabeleceu como o principal canal digital B2B. Para complementar essas iniciativas, em 2023, eclodiu de forma popular todo o conceito de LLMs e a IA generativa, que traz ainda mais competição para o meio digital.

Diante disso, como se encontra o B2B e sua digitalização?

Mercado B2B

A Infracommerce estima que apenas 2,5% do valor transacionado no mercado B2B brasileiro é realizado por meio de e-commerce, totalizando aproximadamente R$ 61 bilhões dos R$ 2,4 trilhões movimentados no setor em 2019, conforme dados do B2BOL. Dentro desse contexto, o setor de Bens de Consumo Rápido (Fast-Moving Consumer Goods – FMCG) destaca-se pela sua grande afinidade com o meio digital.

Para melhor explorar o processo de vendas nesse segmento, proponho dividir a análise em quatro etapas (artigos), cada uma abordando um aspecto específico da cadeia de venda B2B: fornecedor (produtor ou distribuidor), vendedor (RCA ou contratado), comprador (responsável pelo PDV) e o ecossistema criado.

O fornecedor já possui diversos canais em operação – indireto, direto, digital, key accounts – e está cauteloso em relação a embarcar em mais uma jornada, mas, ao mesmo tempo, “todo mundo só fala de IA”, e o receio de estar perdendo uma oportunidade só aumenta. Então, “o que fazer?” Comece pequeno!

Desmistifique a IA. Ela é uma ferramenta, não uma plataforma; e, em virtude disso, ela pode permear muitas etapas de sua operação. Com tanta versatilidade, é necessário ter foco, então avance para o segundo ponto e busque alguns casos de uso de alto impacto – normalmente, esses casos são de tarefas repetitivas e de baixa complexidade – atualmente, áreas como marketing ou atendimento (vendas) estão sendo priorizadas. Tão logo tenha identificado, elenque casos de uso bem específicos – criar uma campanha de posts, criar um passo a passo para o time de vendas – e elabore com seu time uma agenda de noções de sucesso e quais são os principais aprendizados esperados.

A próxima pergunta que você deve se fazer é: “Qual modelo de LLM posso usar?”.

Indicadores de performance LLM

Existem três variáveis às quais você deve ficar atento:

– Conhecimento: grandes modelos de código fechado, como GPT-4 e GPT-4o, foram treinados com mais de 1,7 trilhão de parâmetros, o que os credencia como foundation models, por terem uma concentração de informação quase sem fronteiras.

– Custo: o GPT-4 Turbo, por exemplo, tem uma capacidade de interpretar e retornar texto e imagem a um custo de $10/1M no input e $30/1M tokens no output. Para fins de comparação, você pode considerar que uma palavra equivale a 1.33 tokens aproximadamente. O custo desse modelo em resoluções de problemas em grande escala pode ser considerado caro.

– Tempo: como um alto número de parâmetros usados nos treinamentos normalmente possui tempos de retorno maiores, isso pode gerar algum desconforto ao usuário conforme o caso de uso.

Com base nesses desafios, escolha do problema e do modelo, você pode estar se perguntando: é possível fazer isso acontecer ou encontrar alternativas para o caso de uso?

Grandes modelos de LLMs x pequenos modelos de LLMs

A resposta direta é sim! Existem diversas abordagens para resolver cada uma dessas questões.

Uma opção um pouco mais complexa é baseada no conceito de RAG (Retrieval Augmented Generation). Essa técnica consiste em realizar um treinamento de um modelo com base em parâmetros que você estabelece. Por exemplo, você pode utilizar documentos, imagens e campanhas do time de marketing como referência para treinar o modelo.

A outra pode ser usando modelos com “somente” sete bilhões de parâmetros, como Mistral 7B-32 ou Llama 2, que não possuem a amplitude da fonte de conhecimento como o GPT-4, mas são muito bons em aprender casos específicos de uso, possuem tempos de resposta mais rápidos e valores menores.

Uma terceira opção é o fine-tuning, que será detalhado com o exemplo, pois fizemos essa abordagem quando nos deparamos com o seguinte desafio: imagine que você, fornecedor, recebe em seus canais de vendas, todos os dias, centenas ou milhares de demandas de cotação em textos despadronizados e seu time repetidamente realiza o mesmo procedimento padrão – identifica o cliente, identifica os itens e a quantidade, busca cada produto, consolida os resultados da busca e retorna a informação ao cliente. Esse processo, quando feito para pedidos com mais de 15 itens, geralmente onera a operação devido à dificuldade de interpretar, estruturar e responder a essas demandas, o que gera um efeito negativo a cada hora a mais de espera para o cliente… uma ótima oportunidade para a IA!

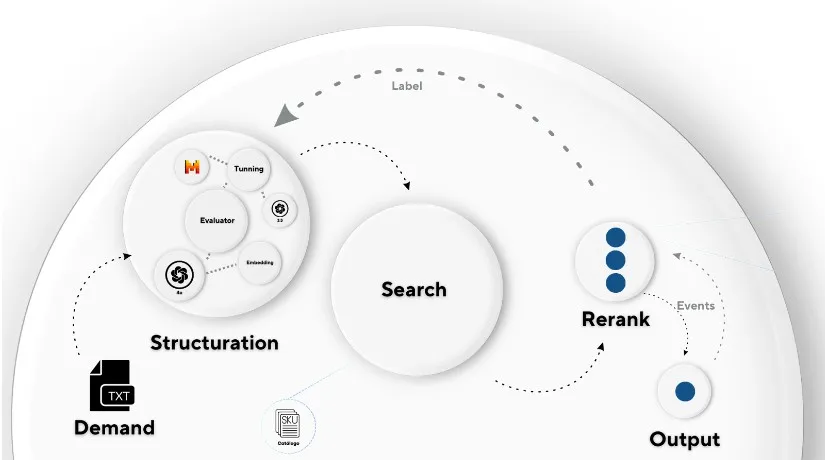

Para realizar a interpretação e o retorno dessa demanda, dividimos esse processo em duas etapas: estruturação e busca. Iniciamos a etapa de estruturação com grandes modelos de LLMs, como o GPT-4, no qual a demanda é recebida e estruturada. Com os dados estruturados, é realizada uma pesquisa semântica na base de produtos. O retorno consiste em uma mensagem com itens cotados, compondo assim a resposta ao usuário.

Os dados da interação são capturados e utilizados para melhorias e novos treinamentos de modelos. Aqui, aplicamos as técnicas de fine-tuned visando a uma melhor eficiência de custo e tempo na etapa de estruturação. Com esses treinamentos acontecendo ao longo do tempo, os modelos mais recentes de estruturação estão pelo menos 2,1 vezes mais rápidos e, em média, 1,4 vezes mais assertivos.

Esse exemplo, juntamente com as etapas anteriores, pode contribuir para estruturar e iniciar um piloto na sua organização.

Mas, antes de começar, você já verificou com o usuário, o vendedor na jornada proposta, como ele se beneficia dessa tecnologia e se torna um agente dessa digitalização?

Se você esteve comigo até agora, muito obrigado! Este é o meu primeiro artigo por aqui, e o seu feedback será muito bem-vindo! Na parte 2, pretendo falar sobre o universo do vendedor e como o tornar um agente da digitalização, até lá!

Fontes:

https://www.mckinsey.com/featured-insights/destaques/a-organizacao-do-futuro-habilitada-pela-ia-generativa-impulsionada-pelas-pessoas/pt

https://ri.infracommerce.com.br/sobre-a-infracommerce/mercado-de-e-commerce/

https://openai.com/api/

https://medium.com/blog-do-zouza/comparando-llms-large-language-models-945c9268c52f

https://exame.com/tecnologia/vendas-de-smartphones-no-brasil-mais-que-dobram-em-2013/